Avec une communauté croissante de plus de 3 milliards de joueurs dans le monde, il est essentiel de continuer à investir dans la confiance et la sécurité pour favoriser un environnement en ligne sûr et inclusif. Protéger les joueurs des dangers fait partie intégrante de l’équipe Xbox Safety et du travail que nous effectuons. Les joueurs ne voient pas souvent ou ne connaissent pas toutes les mesures de modération de contenu fonctionnant en arrière-plan qui contribuent à rendre leur expérience plus sûre et plus accueillante. Aujourd’hui, nous publions notre deuxième Rapport de transparence Xboxqui détaille les efforts continus pour mieux protéger nos joueurs et illustre nos mesures de sécurité en action.

Notre suite de sécurité à multiples facettes comprend nos efforts de modération proactifs et réactifs, les normes communautaires, les contrôles parentaux et familiaux tels que l’application Xbox Family Settings, et notre travail continu avec les partenaires de l’industrie et les régulateurs. Nos investissements critiques dans la modération de contenu combinent l’IA et des technologies à propulsion humaine pour intercepter et filtrer le contenu avant qu’il n’atteigne et n’affecte les joueurs. Nous utilisons une gamme de mesures qui nous donnent l’échelle, la vitesse et l’étendue nécessaires pour suivre les interactions et les activités croissantes de nos joueurs. Comme indiqué dans le rapport sur la transparence, 80 % (8,08 millions) du nombre total d’applications au cours de cette période ont été réalisées grâce à nos efforts de modération proactive. Les données articulent l’impact de cette approche.

Alors que les besoins des joueurs continuent d’évoluer, nos outils évoluent également. La sécurité de nos joueurs est une priorité absolue – et pour faire progresser des expériences en ligne sûres, nous continuerons d’investir dans l’innovation, de travailler en étroite collaboration avec les partenaires de l’industrie et les régulateurs, et de recueillir les commentaires de la communauté. Nous avons hâte de partager plus.

Parmi les principaux points à retenir du rapport :

- Les mesures proactives sont un facteur clé pour des expériences de jeu plus sûres. En cette période, 80% du total de nos mesures d’exécution émises sont le résultat de nos efforts de modération proactive. Notre approche de modération proactive comprend à la fois des mesures automatisées et humaines qui filtrent le contenu avant qu’il n’atteigne les joueurs. Des outils automatisés tels que Community Sift fonctionnent sur du texte, des vidéos et des images en capturant le contenu offensant en quelques millisecondes. Au cours de la dernière année seulement, Community Sift a évalué 20 milliards d’interactions humaines sur Xbox.Des mesures proactives ont également été détectées et appliquées contre 100% de falsification de compte, de piratage, d’hameçonnage et de triche/comptes non authentiques.

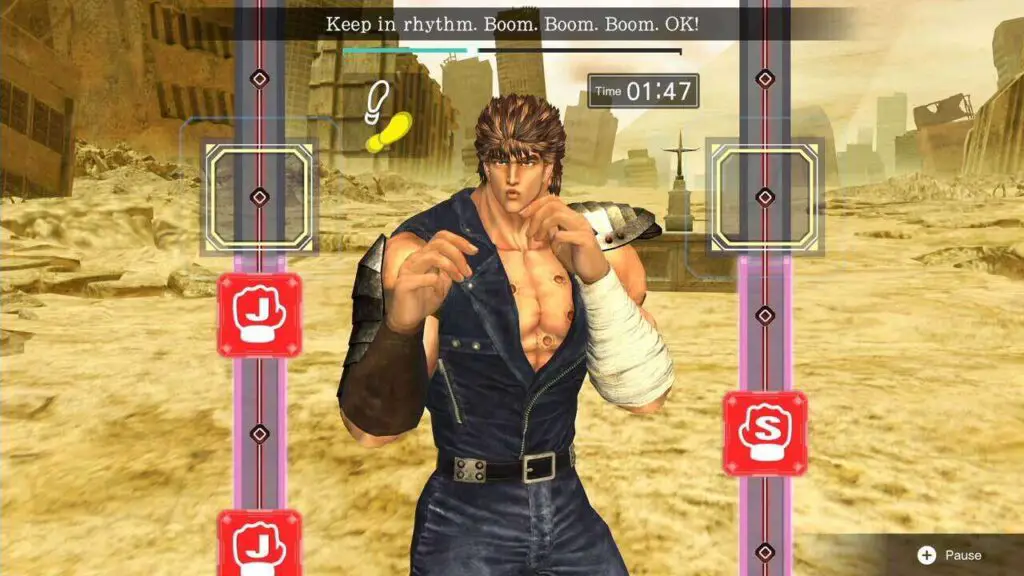

- Accent accru sur le contenu inapproprié. Nous comprenons que les besoins de nos joueurs évoluent constamment et nous continuons à écouter les commentaires des joueurs sur ce qui est ou n’est pas acceptable sur la plateforme, conformément à nos normes communautaires. Au cours de cette dernière période, nous avons élargi notre définition du contenu vulgaire pour inclure les gestes offensants, le contenu sexualisé et l’humour grossier. Ce type de contenu est généralement considéré comme désagréable et inapproprié, nuisant à l’expérience de jeu de base pour nombre de nos joueurs. Ce changement de politique, associé aux améliorations apportées à nos classificateurs d’images, a entraîné une 450% d’augmentation dans l’application des contenus vulgaires, avec 90,2 % être modéré de manière proactive. Ces mesures d’application aboutissent souvent à la simple suppression du contenu inapproprié, ce qui se reflète dans la 390% d’augmentation dans les applications « contenu uniquement » au cours de cette période.

- Accent continu sur les comptes non authentiques. Notre modération proactive, en hausse 16,5x de la même période l’année dernière, nous permet d’attraper le contenu et les comportements négatifs avant qu’ils n’atteignent les joueurs. L’équipe Xbox Safety a publié plus de 7.51M des mises en application proactives contre les comptes non authentiques, représentant 74% du nombre total d’exécutions au cours de la période de référence (au lieu de 57% dernière période de déclaration). Les comptes non authentiques sont généralement des comptes automatisés ou créés par des robots qui créent des règles du jeu inégales et peuvent nuire aux expériences positives des joueurs. Nous continuons d’investir et d’améliorer notre technologie afin que les joueurs puissent vivre des expériences sûres, positives et invitantes.

Partout dans le monde, notre équipe continue de travailler en étroite collaboration avec des partenaires clés de l’industrie pour collaborer sur notre approche de la sécurité, y compris une éducation accrue et l’amélioration de nos mesures de sécurité pour dépasser les normes :

Ensemble, nous créons une communauté où chacun peut s’amuser. Chaque personne, qu’il s’agisse d’un joueur débutant ou d’un professionnel chevronné, joue un rôle dans la construction d’une communauté plus positive et invitante pour tous. Les commentaires et les rapports des joueurs nous aident à améliorer nos fonctions de sécurité. Si vous voyez quelque chose d’inapproprié, veuillez le signaler – nous ne pourrions pas le faire sans vous !

Quelques ressources supplémentaires :